Alors que de plus en plus de puces-systèmes SoC intègrent des accélérateurs matériels d’algorithmes d’intelligence artificielle (IA) et autres moteurs neuronaux, Cadence, l’un des principaux fournisseurs de blocs d’IP, apporte son écot à cette tendance lourde ...avec une offre destinée aux concepteurs de puces et présentée comme couvrant désormais l’intégralité des besoins en matière de traitement IA embarqué et edge, de l’entrée jusqu'au haut de gamme.

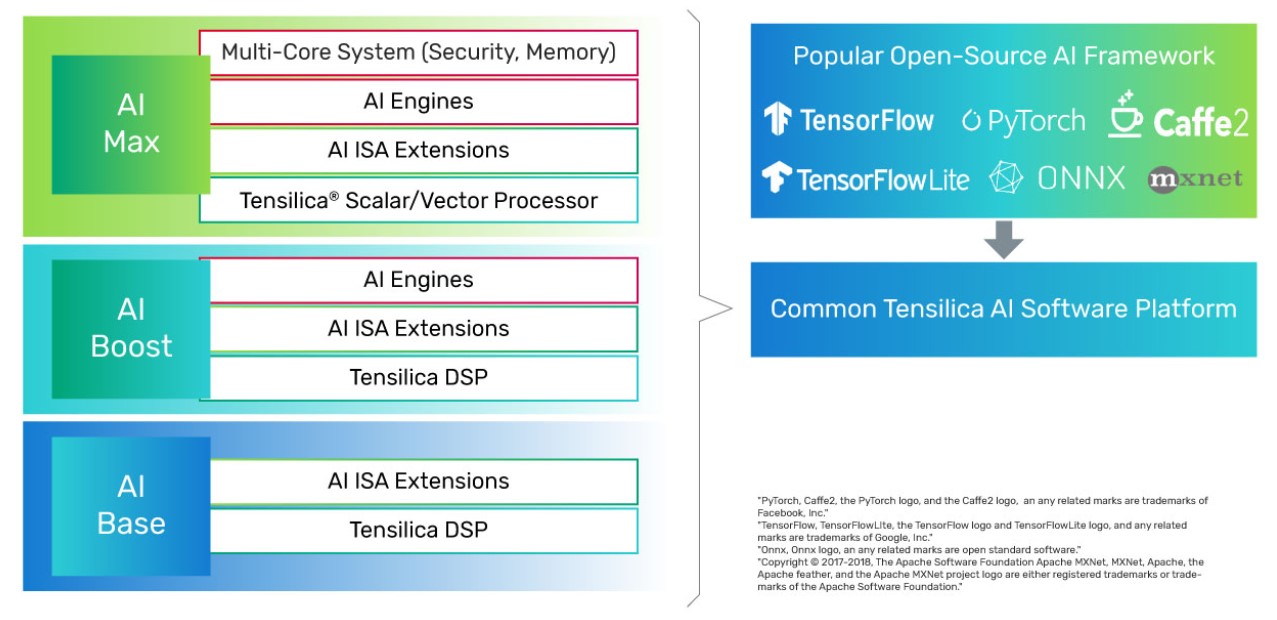

Baptisée Tensilica AI Platform, cette offre se décline aujourd’hui en trois familles de produits baptisées respectivement AI Base, AI Boost et AI Max, qui visent des applications aussi diverses que les capteurs intelligents, les applications vocales et de vision dans les terminaux mobiles et les objets connectés ou les systèmes d’assistance évolués à la conduite automobile (ADAS). Selon Cadence, l’ensemble, rassemblé sous une plate-forme logicielle commune pour une échelonnabilité maximale, a été optimisé au niveau consommation, performances et empreinte silicium.

Dans le détail, l’offre AI Base se décline autour des cœurs de DSP Tensilica bien connus de Cadence (HiFi, Vision, ConnX) agrémentés ici d’extensions IA au jeu d’instructions. Les plates-formes AI Boost y ajoutent un moteur IA neuronal (NNE), dont la première version est estampillée Tensilica NNE 110 avec des performances comprises entre 64 et 256 Gops (gigaopérations par seconde) et qui peut exécuter en simultané des opérations de traitement du signal et des inférences IA. Si l’on en croit Cadence, ce nouveau moteur neuronal consomme 80% moins d'énergie par inférence que les DSP Tensilica autonomes et fournit un rapport Tops/W plus de quatre fois supérieur.

Enfin l’offre AI Max intègre la famille d'accélérateurs IA Tensilica NNA, qui comprend actuellement l'accélérateur Tensilica NNA 110 et les options multicœurs NNA 120, NNA 140 et NNA 180, et qui intègre les technologies AI Base et AI Boost (voir illustration ci-dessous). Les accélérateurs NNA multicœurs peuvent fournir aujourd’hui jusqu'à 32 Tops, et les futurs produits NNA devraient pouvoir offrir jusqu'à des centaines de Tops, assure Cadence.

Les moteurs et accélérateurs NNE et NNA intègrent des mécanismes destinés à améliorer les performances, abaisser la bande passante mémoire et réduire la taille des modèles IA, précise encore la société américaine.

Au sein de l’environnement logiciel fourni avec la plate-forme Tensilica AI, se niche en particulier le compilateur de réseau de neurones neuronal Tensilica qui prend en charge des frameworks standard de l'industrie comme TensorFlow, ONNX, PyTorch, Caffe2, TensorFlow Lite et MXNet pour la génération automatisée de code de bout en bout. On y trouve aussi les environnements Android Neural Network Compiler, TFLite Delegates pour l’exécution en temps réel et TensorFlow Lite Micro pour les puces de classe microcontrôleur. « Alors que les applications IA migrent rapidement du cloud à la périphérie de réseau, l'intégration d'un accélérateur d'IA au sein même des puces-systèmes est devenue indispensable pour répondre aux exigences de faible latence dans les systèmes ADAS, les capteurs mobiles et intelligents ou l’internet des objets, rappelle Mike Demler, analyste pour The Linley Group. Avec les technologies Tensilica AI Base, AI Boost et AI Max, Cadence fournit une voie de migration claire adaptée à l’évolution des exigences en matière de performances et de consommation. »

La disponibilité générale du moteur IA NNE 110 et de la famille d'accélérateurs IA NNA 1xx est prévue dans le courant du quatrième trimestre 2021.

Vous pouvez aussi suivre nos actualités sur la vitrine LinkedIN de L'Embarqué consacrée à l’intelligence artificielle dans l’embarqué : Embedded-IA

-blocks-basic-fr.jpg)