Fondée en 2015 et initialement connue sous le nom de Deep Vision, la société américaine Kinara, qui a conçu un processeur d’inférence destiné à exécuter des applications de périphérie de réseau (edge) tirant parti des technologies de l’intelligence artificielle (IA), dévoile sous le nom d'Ara-2 une puce de deuxième génération. Cette dernière est destinée aux serveurs edge et s'avère dotée d’une efficacité énergétique (performances/watt) et d’un rapport performance/coût nettement plus élevés que son aînée.

L’Ara-2, qui s’appuie sur la même architecture que l’Ara-1 (lire notre article), est conçu pour faire tourner des applications telles que l’analyse vidéo, les grands modèles de langage (LLM) et d'autres modèles d’IA générative. La puce répond également aux besoins des applications edge faisant tourner des modèles IA classiques et des modèles IA innovants dotés d’architectures de type transformeurs, ajoute Kinara. Doté de performances 5 à 8 fois supérieures à celles de l’Ara-1, l’Ara-2 de Kinara est censé associer la réactivité temps réel et un haut débit de traitement en fusionnant une conception optimisée à faible latence avec des capacités mémoire dûment équilibrées et une bande passante hors puce élevée afin que les très grands modèles puissent s’exécuter avec une latence extrêmement faible, résume la firme américaine.

Les grands modèles de langage et l’IA générative en général sont devenus particulièrement populaires, rappelle Kinara, mais la plupart des applications ad hoc tournent aujourd’hui sur des processeurs graphiques (GPU) au sein de centres de données et sont handicapées par une grande latence, des coûts élevés et une sécurité des données douteuse.

Pour relever ces défis, le processeur Ara-2 de Kinara simplifie la transition vers la périphérie de réseau grâce à sa compatibilité avec les dizaines de milliards de paramètres utilisés par les modèles d’IA générative, affirme la start-up. De plus, afin de faciliter la migration, les moteurs de calcul du Ara-2 et le kit de développement logiciel associé (SDK) sont spécifiquement conçus pour assurer une quantification ultraprécise, un temps d'exécution modéré au niveau hôte et une compatibilité directe avec les formats FP32.

« Alors que le processeur Ara-1 est la solution qui convient pour les caméras intelligentes ainsi que pour les appareils Edge IA gérant de 2 à 8 flux vidéo, l’Ara-2 est fortement recommandé pour la gestion de 16 à 32 flux vidéo (voire plus) au sein de serveurs de périphérie, d’ordinateurs portables, voire de caméras haut de gamme », précise Ravi Annavajjhala, le CEO de Kinara. Au niveau de la capacité de traitement des modèles d’IA générative, l'Ara-2 peut assurer une vitesse d’environ 0,5 seconde par itération pour le modèle d’apprentissage automatique Stable Diffusion (qui permet de générer des images numériques photoréalistes à partir de descriptions en langage naturel) et jusqu'à plusieurs dizaines de tokens/seconde pour le modèle LLaMA-7B.

Outre ses huit cœurs neuronaux et sa capacité à adresser jsqu’à 16 Go de mémoire LPDDR4, l’Ara-2 dispose également d’une fonction de démarrage sécurisé, d’accès mémoire chiffrés et d’une interface d’hôte sécurisée pour permettre les déploiements IA en entreprise avec encore plus de sécurité, précise encore Kinara.

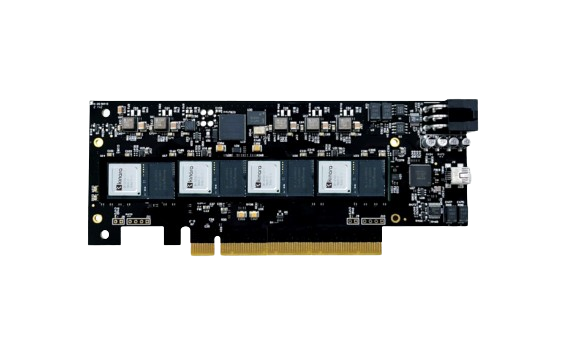

Le SDK associé comprend un compilateur de modèle et un programmateur d’unité de traitement, des options de quantification flexibles dont le quantificateur Kinara intégré et la prise en charge des modèles préquantifiés PyTorch et TFLite, ainsi qu’un équilibreur de charges pour les systèmes multipuces et un exécutif hôte. L’Ara-2, qui sera en démonstration début janvier sur le salon CES, est disponible en tant que composant autonome ou sous forme de module USB, de module M.2 et de carte PCIe intégrant plusieurs processeurs Ara-2 (photo ci-dessus).

Le SDK associé comprend un compilateur de modèle et un programmateur d’unité de traitement, des options de quantification flexibles dont le quantificateur Kinara intégré et la prise en charge des modèles préquantifiés PyTorch et TFLite, ainsi qu’un équilibreur de charges pour les systèmes multipuces et un exécutif hôte. L’Ara-2, qui sera en démonstration début janvier sur le salon CES, est disponible en tant que composant autonome ou sous forme de module USB, de module M.2 et de carte PCIe intégrant plusieurs processeurs Ara-2 (photo ci-dessus).

Vous pouvez aussi suivre nos actualités sur la vitrine LinkedIN de L'Embarqué consacrée à l’intelligence artificielle dans l’embarqué : Embedded-IA

-dissolve-basic-fr_650x100.jpg)