La jeune société parisienne Chronocam a développé une technologie inédite de vision embarquée qui mime le fonctionnement de la rétine de l’œil humain. Une technologie qui associe pour la première fois grande vitesse d’acquisition des images, faibles débits des informations à véhiculer et éco-efficacité ! ...

Révolutionner la vision industrielle et embarquée, balayer d’un revers de la main les sempiternels compromis à trouver entre vitesse d’acquisition des images et débits d’informations à véhiculer, puis mettre le résultat à la portée de (presque) tous les objets connectés et capteurs répartis dans les domaines de l’IoT, de la robotique, de l’automobile, du biomédical, de la Défense et de l’aéronautique. Voilà résumée en quelques mots l’ambition de la jeune société française Chronocam, mise sur pied en 2014 pour commercialiser des systèmes de vision aptes à mimer le fonctionnement de la rétine de l’œil humain. Rien de moins ! Mais Paris ne s’est pas fait en un jour…

Luca Verre, cofondateur et CEO de Chronocam

Luca Verre, cofondateur et CEO de Chronocam

« La création de Chronocam est l’aboutissement de 15 ans d’incubation dans plusieurs centres de recherche et développement en Europe, et notamment à l’Institut de la vision de l’université Pierre et Marie Curie (UPMC) et à l’Austrian Institute of Technology (AIT) », rappelle Luca Verre, cofondateur et CEO de la start-up parisienne. De fait, parmi les autres cofondateurs de l’entreprise figurent Christoph Posch et Ryad Benosman, professeurs à l’UPMC, codirigeants du groupe Vision and Natural Computing de l’Institut de la vision et respectivement directeur technique (CTO) et conseiller scientifique (CSO) de Chronocam. L’équipe à la tête de la jeune pousse est complétée par Bernard Gilly, célèbre entrepreneur en série du domaine des biotechnologies.

Une dizaine de brevets

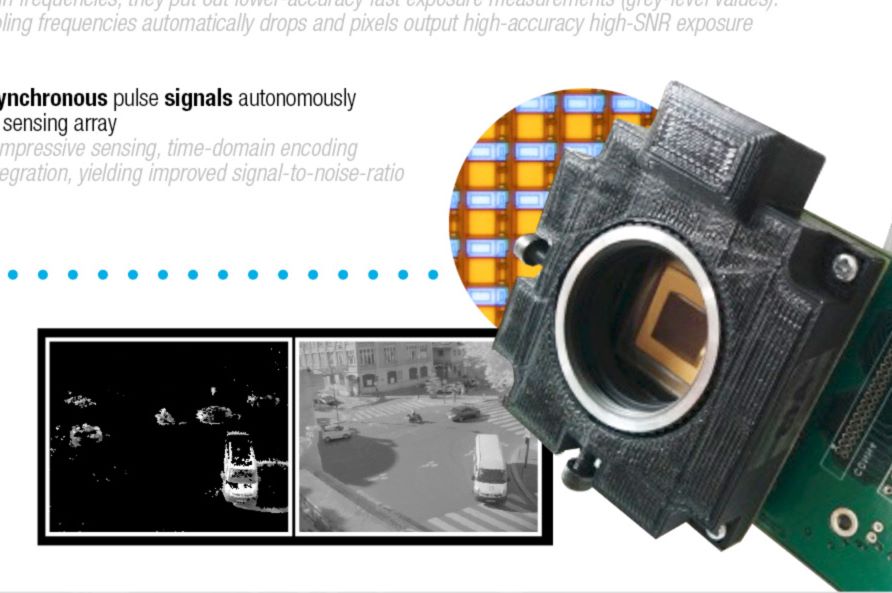

« La technologie que nous avons baptisée du nom de CCAM (Eye)oT repose sur une dizaine de brevets dont Chronocam détient la licence d’exploitation exclusive et qui couvrent à la fois la conception du capteur d’image et l’algorithme de traitement associé qui est adapté à la manière dont les images sont acquises », précise Luca Verre. L'approche est en effet originale. Au sein du système de vision développé par la start-up, l’acquisition des images ne se fait pas trame par trame comme dans les capteurs Cmos traditionnels. Dans la technologie CCAM (Eye)oT, tous les pixels sont indépendants les uns des autres et fonctionnent de façon totalement asynchrone. Couplé à un petit processeur analogique, chaque pixel est alors capable d’optimiser son temps d’acquisition en fonction de la dynamique de la scène, avec la possibilité de récupérer de l’information uniquement s’il y a un changement dans l’image et ce dans un laps de temps de l’ordre de la microseconde si cela s’avère nécessaire.

.jpg)

« Dès lors, le capteur, en évitant d’enregistrer des événements redondants, génère beaucoup moins de données ; le débit nécessaire à la transmission du contenu réellement pertinent s’en trouve considérablement réduit, tout comme la consommation d’énergie, détaille Luca Verre. Par ailleurs, chaque pixel peut optimiser son temps d’exposition en fonction de la lumière ambiante et, partant, le système affiche une large gamme dynamique. » En conséquence, assure Chronocam, une caméra Cmos basée sur la technologie CCAM (Eye)oT affiche des caractéristiques qui jusqu’ici n’avaient jamais pu être associées en même temps dans un seul produit : la vitesse d’acquisition (équivalente à 100 000 images/s), une grande gamme dynamique (>120 dB), un fort taux de compression au niveau du capteur lui-même (100x) et une faible consommation (<10 mW).

En démonstration sur IoT Planet 2015

En démonstration sur IoT Planet 2015

La jeune société a récemment démontré les capacités de sa technologie sur diverses manifestations, comme ce fut le cas à l’occasion de la conférence IoT Planet 2015 qui s’est tenue début novembre à Grenoble. Le visiteur pouvait y comparer les images prises par une caméra traditionnelle (la vue d’un boulevard sillonné par des véhicules en l’occurrence) et celles d’un modèle Chronocam (voir ci-contre). « Dans notre cas, la vidéo est générée uniquement par les événements acquis au niveau de chaque pixel, nous a indiqué le CEO de la start-up à cette occasion. La caméra produit une image où des niveaux de gris apparaissent uniquement là où il y a des mouvements ; le flux généré avec une précision de l’ordre de la microseconde est donc faible et, en sortie de capteur, on a déjà une information pertinente. Les algorithmes mathématiques pour effectuer de la détection, du suivi, voire de la reconnaissance sont donc beaucoup plus simples à mettre en œuvre ! »

Pour l'imagerie 3D embarquée

En réalité, avant même la création de Chronocam, une caméra basée sur la technologie CCAM (Eye)oT avait été développée dans le cadre d’une collaboration entre l’Institut de la vision de l’UPMC et la société Pixium Vision. Et ce pour une application bien spécifique : les systèmes de restauration de la vision pour les personnes atteintes de cécité. « En fait, Chronocam a été fondé pour porter la technologie vers d’autres types d’applications », révèle Luca Verre. Parmi les marchés ciblés aujourd’hui par la start-up, figure en bonne place l’imagerie 3D pour des applications de navigation embarquée dans des drones, des robots, des automobiles… avec une paire de caméras reliées par une troisième carte électronique et associées à des algorithmes de reconstitution de scènes et de concaténation d’événements. « Le marché de la sécurité et de la surveillance dans les réseaux liés à l’Internet des objets s’avère également porteur pour Chronocam, avec la possibilité de porter de la vision et de l’intelligence directement au niveau des capteurs, ajoute le dirigeant de la jeune pousse française. Nous menons également des études dans le domaine de la détection rapide pour des applications sur les secteurs de la Défense et de l’aérospatial, avec des développements qui pourraient se concrétiser en 2016. »

Une troisième levée de fonds prévue début 2016

Déjà fort d’un effectif de dix personnes renforcé par une dizaine de consultants extérieurs, Chronocam compte commercialiser ses premiers produits « dans quelques mois » sous la forme de minimodules constitués du capteur, de la carte imageur et d’une carte support embarquant l’algorithmique (sur FPGA) et dotée de diverses interfaces d’entrées/sorties (USB 3.0, SPI, etc.). « Nous avons déjà bénéficié de deux apports financiers, précise encore Luca Verre. Une première levée de fonds de 750 000 euros a été effectuée en 2014 auprès de business angels et nous avons bouclé un deuxième tour de 750 000 € l’été dernier auprès de Robert Bosch Venture Capital et CEA Investissement. Et nous envisageons d’ores et déjà un nouveau tour de table pour le premier semestre 2016. » A suivre donc !

-dissolve-basic-fr_650x100.jpg)