S’il est bien un domaine où l’utilisation d’algorithmes d’intelligence artificielle (IA) prend tout son sens, c’est bien celui de l’analyse d’image et des systèmes de vision. Le japonais Sony en fait aujourd’hui la démonstration vivante en annonçant la sortie imminente de deux capteurs d’image "intelligents", ...les premiers - selon la société - à être directement équipés de fonctionnalités de traitement de type IA, avec notamment une fonction d’extraction des seules données nécessaires pour l’IA. Éliminant de ce fait les problèmes de temps de latence observés lorsque l’on utilise des services dans le cloud, ainsi que les problèmes de confidentialité des données. Selon Sony, ces capteurs élargissent les opportunités de développement de caméras équipées d'IA, ouvrant la voie à une vaste gamme d'applications dans l’industrie.

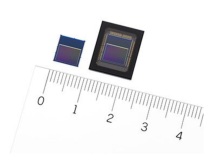

D’un point de vue technique, les deux capteurs, référencés IMX 500 (puce nue) et IMX 501 (puce en boîtier LGA), se composent de deux circuits superposés : une puce dite "pixel" et une puce dite "logique". C’est sur cette dernière que sont implantés des algorithmes de traitement et d'analyse d'image. Le signal acquis par la puce pixel est traité directement sur la puce logique par un processeur de traitement d'image ISP (Image Signal Processor) et un DSP réservé au traitement IA et associé à de la mémoire, éliminant ainsi le besoin de processeurs hautes performances ou de mémoire externe pour le développement de systèmes d’intelligence artificielle embarqués. Le capteur génère des métadonnées (informations sémantiques liées aux données propres à une image) au lieu de données brutes de l'image, ce qui réduit le volume de données à traiter et répond aux problèmes de confidentialité.

Au-delà, indique Sony, la capacité des logiciels d’IA autorise la mise en œuvre directe au plus près du terrain d’applications industrielles, comme par exemple le suivi d'objets en temps réel avec des traitements à grande vitesse.

Au-delà, indique Sony, la capacité des logiciels d’IA autorise la mise en œuvre directe au plus près du terrain d’applications industrielles, comme par exemple le suivi d'objets en temps réel avec des traitements à grande vitesse.

Selon Sony, lorsqu'une vidéo est enregistrée à l'aide d'un capteur d'image conventionnel, il est nécessaire d'envoyer en sortie des données individuellement pour chaque image pour ensuite réaliser un traitement d’IA, ce qui augmente le volume de données transmises et rend difficile l’accès à des performances en temps réel. Avec les capteurs IMX de Sony, le processus complet de traitement de l’image et de son analyse par l’IA se fait sur chaque image dans le capteur (*) permettant le suivi en temps réel d’objets avec une haute précision lors d’un enregistrement vidéo. Différents modèles d'IA peuvent également être choisis en réécrivant la mémoire interne en fonction des besoins de l'utilisateur ou des conditions de l'emplacement où le système est utilisé. En plus d’une image enregistrée par le capteur d'image conventionnel, les utilisateurs peuvent aussi sélectionner le format de sortie des données en fonction des besoins, y compris des images au format YUV/RGB et/ou des images extraites d’une zone spécifique d’intérêt dans l’image globale.

La puce pixel, rétroéclairée, possède environ 12,3 mégapixels pour capturer des informations sous un grand angle de vue, avec une diagonale de 7,8 mm, un débit d’image de 60 images/s et une prise en charge des vidéos 4K.

A noter que cette technologie de superposition de puces développée par Sony, avec des interconnections via des plots de cuivre, a conduit récemment au développement, avec la société française Prophesee, d’un circuit de détection d’objets en mouvement qui s’appuie sur le capteur neuromorphique de cette dernière. Pour rappel, la technologie de Prophesee permet aux capteurs et caméras de visualiser et d’analyser des événements extrêmement rapides en mimant le fonctionnement de la rétine de l’œil humain. Ainsi l’acquisition des images ne se fait pas trame par trame comme dans les capteurs Cmos traditionnels, mais via une analyse d’une scène en s'appuyant sur des pixels indépendants les uns des autres et fonctionnant de façon asynchrone. Si bien que chaque pixel ne s'active que s'il détecte un changement dans la scène en observation.

Cette approche dirigée par les événements permet de capturer des données plus rapidement qu'avec un capteur d'image classique et ne génère qu’un flux de données modeste sans consommer beaucoup d'énergie. En l'occurrence ce capteur présenté en février dernier lors de la conférence ISSCC, mais dont la date de mise sur le marché n’a pas été communiquée, pourra capturer 100 000 événements par seconde en consommant 32 mW ou 300 millions d'événements par seconde en consommant 73 mW pour une résolution de 1280×720 pixels et une dynamique de 124 dB.

(*) La durée du traitement IA est de 3,1 millisecondes avec le modèle en open source MobileNet V1, un réseau de neurones convolutif pour les applications de vision mobile

Vous pouvez aussi suivre nos actualités sur la vitrine LinkedIN de L'Embarqué consacrée à l’intelligence artificielle dans l’embarqué : Embedded-IA

-blocks-basic-fr.jpg)